Der Wettkampf um den entscheidenden Vorteil beschränkt sich im Spitzensport längst nicht mehr auf Training und Spielfeld. Das gilt insbesondere in hochprofessionalisierten Mannschaftssportarten wie, z. B. im Fußball. Begeisterung, Anstrengung und die Unsicherheit des Ergebnisses bilden nach wie vor das Fundament für die Popularität von sportlichen Wettkämpfen.

Aber entscheidende Wettbewerbsvorteile werden zunehmend in Backoffices und „Analytics Departments“ erarbeitet. Hier werden Daten gesammelt, analysiert und aufbereitet, um verlässlich gute Entscheidungen zu ermöglichen – von der Kaderzusammenstellung über die taktische Ausrichtung bis hin zum Management der Spielerbelastung und des Verletzungsrisikos.

Datenbasierte Entscheidungsunterstützung

Auf den ersten Blick erscheint diese Entwicklung zumindest im Spitzensport alternativlos. In anderen Bereichen, in denen Entscheidungen von hoher Relevanz unter Unsicherheit getroffen werden müssen, wird der Kombination aus breit angelegter Datenintegration, maschinellem Lernen und künstlicher Intelligenz ein ähnliches Potenzial zugebilligt. Ein Beispiel ist die Medizin [1]. Andererseits ist eine „datengetriebene“ Vorgehensweise in beiden Bereichen nicht unumstritten. Neben Bedenken in Bezug auf Fairness, Datenschutz und Sportsgeist, bedeuten mehr Daten auch nicht automatisch einen Wettbewerbsvorteil. Vielmehr sind Informationsüberflutung und Zeitdruck bekannte Hemmnisse für gute Entscheidungen. Hier können computergestützte Verfahren sicherlich wirksame Unterstützung bieten. Beispiele reichen von Smartphone-basierten Fragebögen über Datenbanksysteme mit Schnittstellen zu diversen Wearables, die Berechnung informativer Indikatoren aus wenig aussagekräftigen Rohdaten und deren intuitive Visualisierung, bis zur automatischen Annotation von Videoaufnahmen. Die Vorteile digitaler Lösungen für Datenmanagement und -aufbereitung stehen dabei außer Frage. Allerdings handelt es sich lediglich um vorbereitende Schritte. Die zentrale Herausforderung von Entscheidungsfindung und -unterstützung ist ein Blick in die Zukunft: Die Abschätzung der potenziellen Ergebnisse verfügbarer Handlungsoptionen (wie z. B. Regenerationsmaßnahen, taktische Ausrichtung, Mannschaftsaufstellung etc.) auf Basis der zum Zeitpunkt der Entscheidung vorhandenen Informationen. Diese Vorhersagen – ob implizit oder explizit – erlauben es diejenige Option auszuwählen, die das beste Ergebnis erwarten lässt. Die Schwierigkeit, mit beschränkten Informationen Abschätzungen über die bisherigen Erfahrungen bzw. Daten hinauszutreffen, wird oft mit dem berühmten Zitat des Nobelpreisträgers Niels Bohr illustriert: „Vorhersagen sind schwierig, besonders wenn sie die Zukunft betreffen.“

Erfahrungswissen, Wissenschaftliche Evidenz & Maschinelles Lernen

Traditionell stützt sich die Entscheidungsfindung auf erfahrungsbasiertes Wissen und subjektive Beurteilung. Dabei kann Erfahrungswissen in Form von einfachen, bewährten Regeln, so genannten Heuristiken, weitergegeben werden. Obwohl dieses Vorgehen für ergebnisorientierte Entscheidungen über Jahrtausende alternativlos war, unterliegt es den Begrenzungen von menschlichem Denken und Urteilsvermögen [2]. Im 20. Jahrhundert setzte sich daher auch im Sport zunehmend die evidenzbasierte Entscheidungsfindung durch, bei der wissenschaftliche Studien als Grundlage dienen. In der Medizin hat der systematische Vergleich von klinischer Erfahrung und Vorhersagen auf Basis von wissenschaftlichen Studien gezeigt, dass statistische Vorhersagen in den meisten Fällen der klinischen Einschätzung überlegen sind [3]. Doch dieser evidenzbasierte Ansatz hat auch Nachteile: Gruppenbasierte Erwartungswerte, die auf großen Studien beruhen, können nicht immer auf individuelle Fälle übertragen werden. In einem hochkompetitiven Umfeld wie dem Spitzensport, wo kleine Unterschiede eine große Relevanz haben können, lohnt es sich daher, die Genauigkeit über den Erwartungswert für eine Referenzgruppe hinaus zu optimieren.

Eine naheliegende Option zur Verbesserung der Genauigkeit von Vorhersagen ist die Nutzung erklärender Variablen. Mögliche Implementierungen reichen von der Identifikation spezifischerer Vergleichsgruppen (Stratifizierung) über Regressionsmodelle bis hin zu hochdimensionalen Vorhersagemodellen, die auf flexiblen Algorithmen aus dem Maschinellen Lernen basieren. Maschinelles Lernen bietet – zumindest unter idealen Bedingungen – die Möglichkeit einer präzisen Modellierung auch komplexer Zielgrößen. Analog zum Vergleich zwischen klinischen und statistischen Vorhersagen Mitte des vergangenen Jahrhunderts [3], konnte gezeigt werden, dass Künstliche Intelligenz (KI) der menschlichen Urteilskraft in einigen Bereichen deutlich überlegen ist. Hierzu gehört neben geschlossenen Aufgaben mit bekannten Regeln wie Brettspielen, insbesondere die Mustererkennung sowohl in Bild und Sprache als auch in tabellarischen Daten. Allerdings zeigten sich im Zuge der zunehmenden Anwendung auch die Voraussetzungen und Schwächen von Maschinellem Lernen und KI. Eines dieser Charakteristika ist der enorme Datenhunger. Hochdimensionale, flexible Algorithmen benötigen eine enorme Anzahl von Fällen, um echte Muster von zufälligen Übereinstimmungen zu unterscheiden. Wird diese Voraussetzung nicht berücksichtigt, passt sich das Modell zwar flexibel den Trainingsdaten an, lässt sich aber nicht auf neue Fälle übertragen und führt somit in der praktischen Anwendung zu falschen Vorhersagen. Die Gefahr dieses „overfitting“ ist aus der klassischen Statistik bekannt, z. B. im Kontext der benötigten Fallzahl für die multiple Regression. Maschinelles Lernen ist im Vergleich zu Regressionsmodellen ungleich besser darin, Muster zu finden – bei begrenzten Mengen an Trainingsdaten sogar dann, wenn diese gar nicht da (bzw. nur dem Zufall geschuldet) sind. Ein verwandtes Problem ist mangelnde Robustheit gegen Veränderungen in nicht-modellierten Faktoren. Diese kann zu unvorhersehbarem Verhalten der Modelle in der praktischen Anwendung führen (wo solche Abweichungen in der Regel wesentlich stärker ausgeprägt sind als im standardisierten Studienkontext). In der klinischen Medizin zeigte sich in der Anwendungsbeobachtung zugelassener KI-Modelle bereits mehrfach eine weit hinter den publizierten Werten zurückbleibende Vorhersageleistung (z. B. [4 – 6]), andere prominente Projekte, wie „Watson for Oncology“, eine Kooperation von IBM und dem Memorial Sloan Kettering Cancer Center in den USA, wurden noch vor der Zulassung eingestellt. Diese Beispiele führen die Kontextabhängigkeit der tatsächlichen Leistung von KI-Modellen und die Notwendigkeit einer kritischen Verifikation ihrer Vorhersageleistung unter realistischen Bedingungen vor Augen [7].

Voraussetzungen für erfolgreiches Maschinelles Lernen

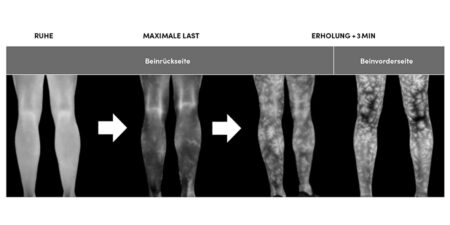

Die Bedeutung großer Datenmengen („big data“) für das Maschinelle Lernen dürfte den meisten Nutzern bekannt sein. Dabei bleibt jedoch häufig im Unklaren, was die „Größe“ eines Datensatzes ausmacht. Die kritische Größe für Maschinelles Lernen ist die Anzahl der Fälle (z. B. der Verletzungen im Datensatz [8]) – nicht die Dateigröße. Eine große Zahl erklärender Variablen (z. B. bei „-omics“ Anwendungen) ist – selbst wenn diese jeweils sinnhaft sind / einen kleinen Beitrag zur Varianzaufklärung leisten – kein Ersatz für eine ausreichende Anzahl von Fällen [9, 10]. Ähnliches gilt für eine große Zahl an Messzeitpunkten (z. B. bei Wearables oder GPS-Daten) [10]. Auch in der zentralen Rolle der Fallzahl unterscheidet sich das Maschinelle Lernen somit nicht von der „klassischen“ Statistik. Und wenn man diese, methodisch unstrittige Spezifizierung berücksichtigt, sind viele Datensätze deutlich kleiner als es die Dateigröße vermuten lässt. Darüber hinaus darf nicht vergessen werden, dass die Passgenauigkeit eines Modells für die Trainingsdaten ein sehr schlechter Indikator ist für dessen Leistungsfähigkeit bei der Anwendung auf neue Fälle – und damit in der praktischen Anwendung. Gerade für typische „black-box“ Modelle, die nicht oder nur indirekt verstanden werden können, gerät diese Jahrzehnte alte Grunderkenntnis [3] schnell aus dem Blick. Dabei ist gerade bei solchen hochflexiblen Modellen die Gefahr des „overfitting“ besonders groß. Eine hervorragende, intuitive Illustration findet sich in [11]. Zusammenfassend kann gesagt werden, dass die Voraussetzungen für erfolgreiches Maschinelles Lernen denen der „klassischen“ Statistik in ihren grundlegenden Prinzipien sehr ähnlich sind, im Grad der Ausprägung (z. B. bei Modellflexibilität und benötigter Fallzahl) aber teilweise weit darüber hinaus gehen. Maschinelles Lernen ist keine „Datenmagie“, die mit hochflexiblen Modellen unbegrenzte Vorhersageleistung aus dem Datensee fischt – auch wenn bei kommerziellen Angeboten manchmal der Eindruck entsteht.

Maschinelles Lernen und gesunder Menschenverstand

Wie also beurteilt man als Sportmediziner oder Sportwissenschaftler die Eignung von Maschinellem Lernen für eine bestimmte Anwendung oder hinterfragt die propagierte Leistungsfähigkeit kommerzieller „KI“-Anwendungen? Die technische Beurteilung eines Modells setzt vertiefte methodische Kenntnisse voraus, nimmt viel Zeit in Anspruch und ist somit in den seltensten Fällen leistbar. Eine Einschätzung ist (im Gegensatz zur Umsetzung) aber auch mit Fachwissen, kritischem Denken und gesundem Menschenverstand möglich. Dafür sollten immer (mindestens) zwei Fragen gestellt werden:

1. Handelt es sich bei Leistungskennzahlen um die Genauigkeit von Vorhersagen für neue Fälle oder um die „Leistung“ des Modells mit den Trainingsdaten? Wichtig: Die Leistung in der Kreuzvalidierung (Cross-Validation) wäre im Zweifel zu letzterem zu zählen [8, 10].

2. Ist die Vorhersagegenauigkeit realistisch? Dabei spielt sowohl die Vorhersagbarkeit der Zielgröße per se eine Rolle (Sportverletzungen haben z. B. meist eine Zufallskomponente) als auch der Informationsgehalt der erklärenden Variablen. Eine fast perfekte Vorhersage akuter Verletzungen in einer Spielsportart ausschließlich auf Basis von GPS-Daten sollte zum Beispiel misstrauisch machen.

Wichtig: Die Frage der Plausibilität der Vorhersagegenauigkeit ist auch dann wichtig, wenn es sich nicht um die Leistung mit den Trainingsdaten handelt. Eine Aufspaltung von Daten in „Trainings- und Test- Daten“ ist schwieriger als man denken könnte. Erhebliche methodische Expertise (und der Wille, auf beeindruckende Leistungsdaten in der Cross-Validation zu verzichten) sind erforderlich, um eine Verunreinigung der Testdaten mit Information aus den Trainingsdaten („leakage“) zu verhindern [8, 12]. Relative Sicherheit bietet hier nur eine prospektive Validierung, d. h. eine Datenaufnahme nach Publikation des anzuwendenden Modells und idealerweise an anderen Personen.

Synergien zwischen künstlicher und humaner Intelligenz

Unter den Rahmenbedingungen im Sport haben alle wesentlichen Strategien – menschliches Erfahrungswissen, wissenschaftliche Evidenz und Maschinelles Lernen – Stärken und Schwächen. Eine alternativlose Strategie, mit der (fast) perfekte Vorhersagen in (fast) allen Anwendungsfällen möglich sind, gibt es nicht. Das gilt auch für Maschinelles Lernen und KI, die unter idealen Rahmenbedingungen eine solche Leistung haben können. Eine ausführliche Darstellung der zugrunde liegenden Überlegungen wurde vor kurzem veröffentlicht [7]. Eine Möglichkeit, die Beschränkungen der einzelnen Strategien zu überwinden, liegt in der Nutzung von Synergien zwischen künstlicher und humaner Intelligenz. Dabei gibt es heute Möglichkeiten, Alleinstellungsmerkmale des menschlichen Urteilsvermögens für formalisierte Modelle nutzbar zu machen. Die am weitesten entwickelte „hybride“ Strategie ist aktuell das interpretierbare Maschinelle Lernen, wie es von der Gruppe um Cynthia Rudin in der Medizin vorangetrieben wird [13, 14]. Erste Anwendungen im Sport befinden sich in der Entwicklung.

Literatur

- Subbiah V. The next generation of evidence-based medicine. Nat Med. 2023;29(1):49-58. Epub 20230116. doi: 10.1038/s41591-022-02160-z. PubMed PMID: 36646803.

- Tversky A, Kahneman D. Judgment under Uncertainty: Heuristics and Biases. Science. 1974;185(4157):1124-31. Epub 1974/09/27. doi: 10.1126/science.185.4157.1124. PubMed PMID: 17835457.

- Meehl P. Clinical versus statistical prediction: A theoretical analysis and a review of the evidence: University of Minnesota Press; 1954.

- Edelson DP, Churpek MM, Carey KA, Lin Z, Huang C, Siner JM, et al. Early Warning Scores With and Without Artificial Intelligence. JAMA Netw Open. 2024;7(10):e2438986. Epub 20241001. doi: 10.1001/jamanetworkopen.2024.38986. PubMed PMID: 39405061.

- Voter AF, Meram E, Garrett JW, Yu JJ. Diagnostic Accuracy and Failure Mode Analysis of a Deep Learning Algorithm for the Detection of Intracranial Hemorrhage. J Am Coll Radiol. 2021;18(8):1143-52. Epub 20210403. doi: 10.1016/j.jacr.2021.03.005. PubMed PMID: 33819478; PubMed Central PMCID: PMC8349782.

- Wong A, Otles E, Donnelly JP, Krumm A, McCullough J, DeTroyer-Cooley O, et al. External Validation of a Widely Implemented Proprietary Sepsis Prediction Model in Hospitalized Patients. JAMA Intern Med. 2021;181(8):1065-70. doi: 10.1001/jamainternmed.2021.2626. PubMed PMID: 34152373; PubMed Central PMCID: PMC8218233.

- Hecksteden A, Keller N, Zhang G, Meyer T, Hauser T. Why Humble Farmers May in Fact Grow Bigger Potatoes: A Call for Street-Smart Decision-Making in Sport. Sports Medicine – Open. 2023;9(1):94. doi: 10.1186/s40798-023-00641-0.

- Hecksteden A, Schmartz G, Egyptien Y, Keller A, Meyer T. Forecasting soccer injuries by combining screening, monitoring and machine learning.ECCS Conference; Sevilla2022.

- Bouchard C. Exercise genomics – a paradigm shift is needed. Br J Sports Med. 2015;49:1492-6.

- Hastie T, Tibshirani R, Friedman J. The Elements of Statistical Learning – Data mining, Inference, and Prediction: Springer; 2017.

- Gigerenzer G, Brighton H. Homo Heuristicus: Why biased minds make better inferences. Topics in Cognitive Science. 2009:107-43.

- Gibney E. Could machine learning fuel a reproducibility crisis in science? Nature. 2022;epub ahead of print. doi: 10.1038/d41586-022-02035-w.

- Rudin C. Stop Explaining Black Box Machine Learning Models for High Stakes Decisions and Use Interpretable Models Instead. Nat Mach Intell. 2019;1(5):206-15. Epub 20190513. doi: 10.1038/s42256-019-0048-x. PubMed PMID: 35603010; PubMed Central PMCID: PMC9122117.

- Struck AF, Ustun B, Ruiz AR, Lee JW, LaRoche SM, Hirsch LJ, et al. Association of an Electroencephalography-Based Risk Score With Seizure Probability in Hospitalized Patients. JAMA Neurol. 2017;74(12):1419-24. doi: 10.1001/jamaneurol.2017.2459. PubMed PMID: 29052706; PubMed Central PMCID: PMC5822188.

Autoren

studierte Medizin in Homburg Saar und Nantes (Frankreich). Ihre sportmedizinische Ausbildung erhielt sie bei Prof. Wilfried Kindermann und Prof. Tim Meyer in Saarbrücken. Hier betreute sie über viele Jahre Athleten am Olympiastützpunkt Saarbrücken und wurde mehrfachzu internationalen Großveranstaltungen entsandt. Seit 2022 leitet sie den gemeinsamen Lehrstuhl für Sportmedizin der Universität Innsbruck und der Medizinischen Universität Innsbruck. Forschungsschwerpunkt ist die Individualisierung in der Sportmedizin einschließlich der Entwicklung digitaler Werkzeuge für die Betreuung im Spitzensport.